Роботы — это программные агенты, которые автоматически сканируют веб-сайты в поисках информации. Они играют важную роль при определении того, какие страницы сайта будут проиндексированы поисковыми системами, а какие останутся скрытыми. Файл Robots.txt – это текстовый файл, который позволяет веб-мастерам установить правила для взаимодействия с роботами.

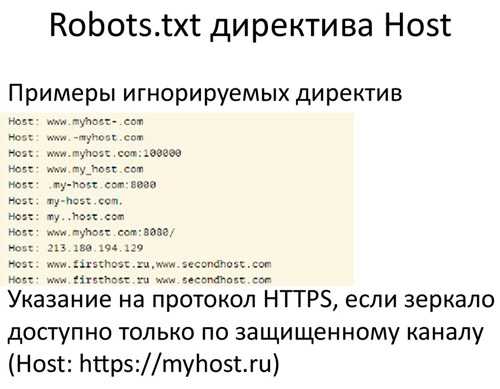

Одной из самых важных директив, которые можно задать в файле Robots.txt, является Host. Эта директива позволяет указать главное зеркало сайта, к которому обращаются роботы при индексации и сканировании. Если на сайте есть несколько зеркал, указание главного зеркала с помощью директивы Host позволяет упростить работу роботам и предотвратить дублирование индексируемой информации.

Директива Host задается в файле Robots.txt следующим образом:

User-agent: *

Host: www.example.com

В данном примере, зеркало www.example.com указывается в качестве главного. Теперь все роботы, которые собираются индексировать сайт, будут обращаться исключительно к нему. Это позволяет предотвратить потерю индексируемой информации и упростить процесс обхода и сканирования сайта для роботов.

Роль файла Robots.txt в SEO

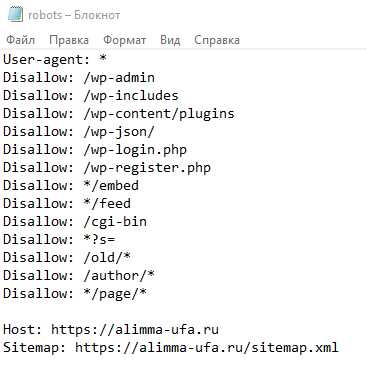

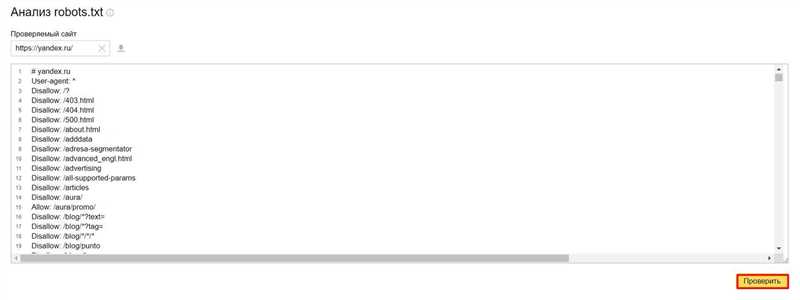

Основная функция файла Robots.txt заключается в указании поисковым роботам, какие разделы сайта они должны индексировать, и какие — нет. С помощью этого файла можно запретить индексацию конкретных страниц, категорий или даже всего сайта в целом, что особенно полезно в случаях, когда нужно скрыть от поисковых систем отдельные части сайта или временно ограничить доступ к ним.

Используя различные директивы, такие как «Disallow», «Allow» и «Sitemap», в файле Robots.txt можно регулировать индексацию, сканирование, частоту обращений поисковых роботов на страницы сайта, а также предоставлять им информацию о карте сайта.

Оптимизация файла Robots.txt имеет большое значение для SEO, так как позволяет более точно направлять действия поисковых роботов на сайте. Правильно настроенный Robots.txt помогает избежать индексации дублирующего контента, что положительно сказывается на ранжировании сайта в поисковой выдаче.

Кроме того, с помощью Robots.txt можно управлять индексацией ресурсоемких страниц и директорий, которые могут замедлять скорость загрузки сайта. Отключив индексацию ненужных разделов, можно ускорить работу поисковых роботов и улучшить общую производительность сайта.

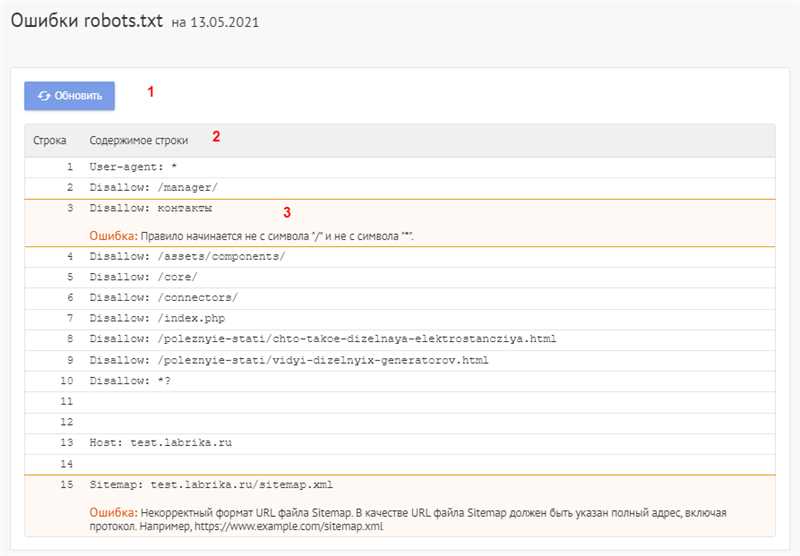

Важно отметить, что несмотря на то, что файл Robots.txt предоставляет указания поисковым роботам, некоторые роботы могут игнорировать эти инструкции. Поэтому для более надежной защиты и контроля индексации и сканирования страниц сайта также рекомендуется использовать мета-теги robots и подключать файлы sitemap.xml.

Конечно, для оптимального использования файла Robots.txt в SEO необходимо учитывать особенности и требования каждой поисковой системы, а также регулярно следить за обновлениями алгоритмов поисковиков и вносить соответствующие изменения в файл, если это необходимо.

Зачем использовать директиву Host?

Использование директивы Host является необходимым для того, чтобы исключить возможность различных проблем и недоразумений, связанных с индексацией и доступностью веб-ресурса. Без указания Host, поисковые роботы могут неправильно интерпретировать правила, указанные в файле Robots.txt, и индексировать не те страницы или директории, которые необходимо ограничить или исключить.

Например, если на сайте имеется несколько поддоменов или зеркал, то использование директивы Host становится особенно актуальным. Правила и ограничения, указанные для одного поддомена, могут не срабатывать или быть применены к другим поддоменам без указания Host. Поэтому, для каждого поддомена или зеркала необходимо указывать основной домен в директиве Host, чтобы поисковым роботам было ясно, к какому домену относятся правила и ограничения.

Использование директивы Host также позволяет эффективно регулировать индексацию и доступность контента на многоязычных сайтах. На таких сайтах каждый языковой раздел может иметь собственный поддомен или подкаталог, и для каждого из них необходимо указывать соответствующий домен или поддомен в директиве Host.

Как использовать директиву Host в файле Robots.txt для выбора главного зеркала?

Чтобы использовать директиву Host в файле Robots.txt для выбора главного зеркала, необходимо выполнить следующие шаги:

- Откройте файл Robots.txt с помощью текстового редактора.

- Добавьте директиву «Host» с указанием основного зеркала сайта. Например, если основное зеркало имеет доменное имя example.com, то директива будет выглядеть следующим образом:

Host: example.com. - Сохраните изменения и загрузите файл Robots.txt на сервер.

После выполнения этих шагов, поисковые роботы будут обращаться к указанному в директиве Host зеркалу сайта для получения информации о разрешенных и запрещенных ресурсах. Это поможет установить основное зеркало сайта и предотвратить возможные проблемы с дублированием контента в поисковых системах.

Важно отметить, что использование директивы Host не гарантирует, что поисковые роботы будут индексировать только основное зеркало сайта. Однако, это средство контроля поможет указывать предпочтительное зеркало при индексации, что может положительно сказаться на SEO-оптимизации сайта.

Наши партнеры: