Оптимизация сайта для поисковых систем — одна из важнейших задач любого веб-мастера. Вместе с тем, не всегда владельцы сайтов хотят, чтобы поисковые роботы индексировали их полностью. Иногда требуется скрыть какие-то части сайта от роботов.

Для этого используется файл <

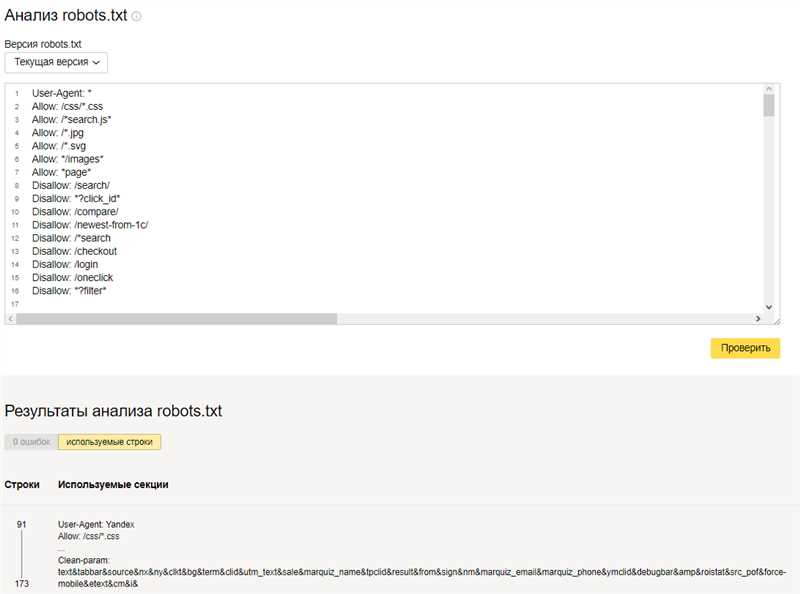

Настройка файла robots.txt требует некоторых знаний и внимания к деталям. Неправильная настройка может привести к проблемам со страницами в поисковой выдаче или даже полной блокировке сайта. Поэтому, прежде чем приступать к редактированию файла robots.txt, рекомендуется провести тщательный анализ сайта и его структуры, чтобы понять, какие именно разделы или страницы нужно скрыть от робота.

Зачем нужен файл robots.txt?

В файле robots.txt содержатся инструкции для роботов, которые определяют, какие области сайта могут быть просканированы и индексированы, а какие следует игнорировать. Он не удаляет страницы из поисковых баз данных, но может предотвратить их индексацию и отображение в результатах поиска.

Файл robots.txt может быть особенно полезен в следующих случаях:

- Ограничение доступа поисковых систем к конфиденциальным страницам или разделам сайта;

- Предотвращение индексации временных или тестовых страниц, которые не должны быть видны в поиске;

- Указание сведений о местонахождении карты сайта (sitemap) и других важных файлов для роботов;

- Блокировка ботов, которые могут негативно повлиять на работу сайта (например, спам-ботов).

Файл robots.txt является важной частью поисковой оптимизации (SEO), так как позволяет контролировать доступ роботов к контенту и структуре сайта. Он должен быть создан и настроен должным образом, чтобы гарантировать, что веб-роботы могут правильно сканировать и индексировать нужные страницы, а нежелательные страницы остаются закрытыми от поисковых систем.

Как правильно настроить файл robots.txt?

При создании файла robots.txt следует учитывать несколько важных моментов. Во-первых, файл должен располагаться в корневой директории сайта, чтобы поисковые роботы могли его найти. Во-вторых, необходимо придерживаться строгого синтаксиса и правил форматирования файла, чтобы избежать ошибок или неправильного восприятия инструкций роботами.

- Файл robots.txt поддерживает несколько команд, которые указываются с помощью ключевого слова «Disallow» или «Allow». Команда «Disallow» указывает на то, какие страницы следует исключить из индексации, а команда «Allow» – наоборот, какие страницы можно индексировать. Например, для запрета индексации всех страниц в директории «example» необходимо использовать следующую инструкцию: «Disallow: /example/».

- Кроме того, можно использовать символ «*» для общих инструкций. Например, команда «Disallow: /images/» запрещает индексацию всех страниц, находящихся в директории «images».

- Также, для более гибкой настройки файла robots.txt можно использовать директиву «User-Agent». Эта директива указывает на конкретного робота и позволяет обозначить инструкции только для него. Например, если нужно запретить индексацию всем роботам, кроме Googlebot, можно использовать следующую инструкцию: «User-Agent: * Disallow: / Allow: /googlebot/».

Важно помнить, что файл robots.txt является открытым файлом и может быть прочитан любыми пользователями или роботами. Поэтому следует избегать размещения в нем конфиденциальной информации или паролей. Также необходимо регулярно проверять правильность настройки файла с помощью специальных инструментов, чтобы убедиться, что роботы не индексируют нежелательные страницы.

Какие секции стоит спрятать от роботов?

При настройке файла robots.txt полезно знать, какие секции вашего сайта стоит скрывать от поисковых роботов. Вот некоторые из них:

-

Каталоги с конфиденциальной информацией: Если на вашем сайте есть каталоги, содержащие конфиденциальные данные, такие как паспортные данные, финансовая информация или личные фото, рекомендуется исключить их из индексации поисковыми роботами. Такое ограничение поможет защитить личные данные ваших пользователей.

-

Временные или тестовые страницы: Во время разработки сайта может возникнуть необходимость создать временную или тестовую страницу. Эти страницы обычно не должны попадать в поисковые результаты, поэтому рекомендуется исключить их из индексации с помощью robots.txt.

-

Внутренние системные страницы: Существуют внутренние системные страницы, которые используются вами или вашей командой разработчиков, но не предназначены для публичного доступа. Если вы не хотите, чтобы эти страницы были обнаружены поисковыми роботами, то лучше исключить их из индексации.

-

Страницы с дублирующим контентом: Если на вашем сайте есть страницы, содержащие дублирующий контент, то рекомендуется исключить их из индексации. Это поможет предотвратить возможные проблемы с дубликатами контента в поисковых результатах.

Обратите внимание, что файл robots.txt лишь рекомендует поисковым роботам, какие страницы следует индексировать или не индексировать. Некоторые поисковые роботы могут проигнорировать указания в файле robots.txt, поэтому важно использовать и другие методы защиты данных и контроля индексации.

Правильная настройка файла robots.txt поможет вам контролировать процесс индексации вашего сайта поисковыми системами, исключая нежелательные страницы из результатов поиска и защищая конфиденциальные данные.

Наши партнеры: